Am Freitag, dem 22.11.2019 fand der Workshop zum Thema UML Modellierung an der Hochschule Pforzheim statt. Geleitet wurde dieser von Andreas Ditze, der von Herrn Prof. Dr. Schuster unterstützt wurde. Andreas Ditze ist Managing Director der MID GmbH und startete pünktlich um 9:45 mit einer Einführung in seine Leidenschaft, die Modellierung.

Am Freitag, dem 22.11.2019 fand der Workshop zum Thema UML Modellierung an der Hochschule Pforzheim statt. Geleitet wurde dieser von Andreas Ditze, der von Herrn Prof. Dr. Schuster unterstützt wurde. Andreas Ditze ist Managing Director der MID GmbH und startete pünktlich um 9:45 mit einer Einführung in seine Leidenschaft, die Modellierung.

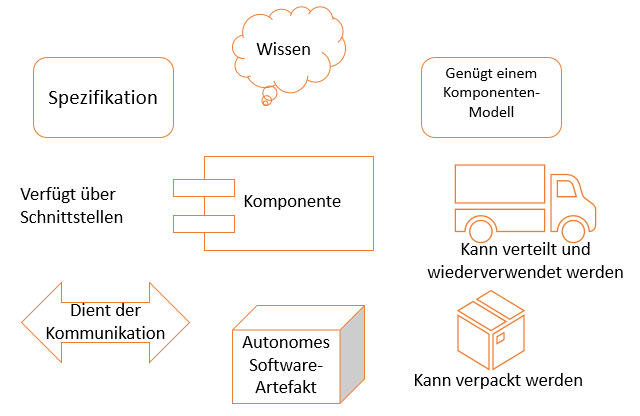

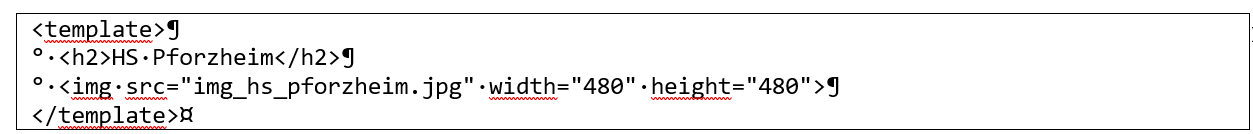

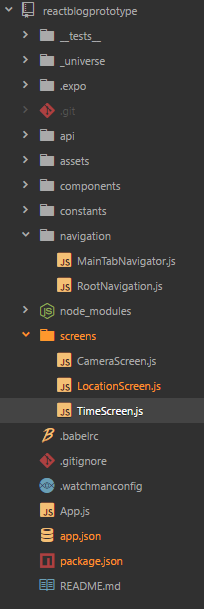

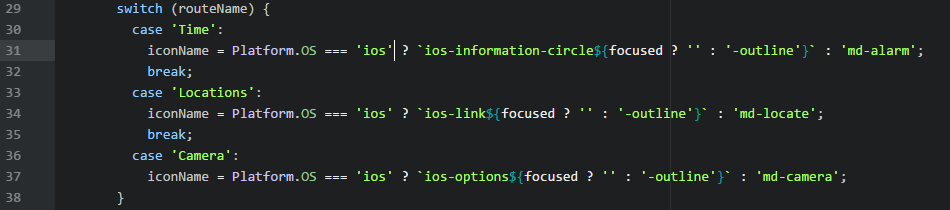

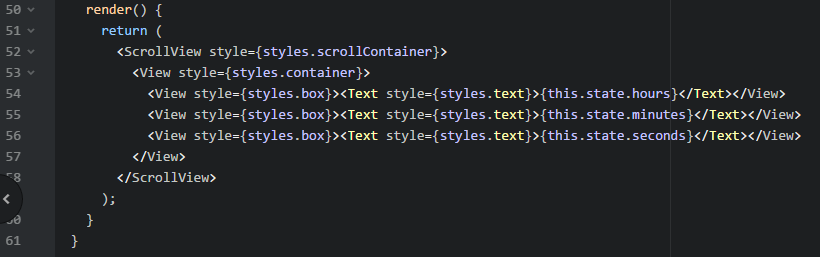

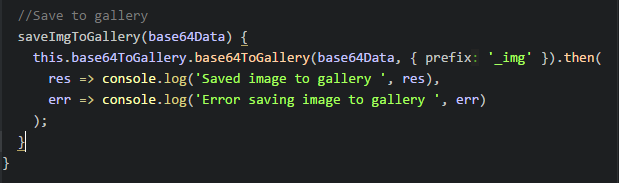

Nach anschließender Vorstellung seiner Firma und ihrer Software, dem Innovator, startete der praktische Teil der Veranstaltung. Die Studenten wurden in Gruppen eingeteilt und durften sich einen Anwendungsfall überlegen. Diese Anwendungsfälle wurden dann durch die Gruppen analysiert und mit Hilfe verschiedener Diagramm Arten modelliert.

Jede Gruppe erhielt darauffolgend Feedback zu ihrem Anwendungsfall und deren Modellierungen sowie konstruktive Kritik. So konnten viele Fehler geklärt und beseitigt werden und die Studenten ein besseres Verständnis für das Thema UML und der zugehörigen Modellierung entwickeln.

Abschließend gaben die Teilnehmer ihr Feedback zur Veranstaltung ab.

Für diesen Beitrag standen Melanie Stitzl und Jennifer Gerhardt für ein kurzes Interview bereit.

Was habt ihr im heutigen Workshop gelernt im Bezug auf Modellierung?

Nachdem die meisten Grundlagen vorab bereits bekannt waren, haben wir unter anderem gelernt auf welche speziellen Regeln geachtet werden muss. Ein weiterer wichtiger Punkt war zu verinnerlichen, was wir an unserem Denkprozess verbessern können, um hochwertigere Diagramme und Prozesse zu erstellen.

Was fandet ihr am heutigen Workshop gut?

Super am Workshop war zusätzlich, dass auf jedes Team gezielt und einzeln eingegangen wurde und deshalb keine Fragen offen blieben. Das dennoch kritisches und konstruktives Feedback gegeben wurde und der gesamte Workshop hauptsächlich praktisch ablief und nicht wie eine klassische Vorlesung.

Gab es auch Punkte die ihr gerne verbessert sehen würdet?

Da wir in der letzten Reihe saßen, war es kaum möglich den Zeichnungen von Herrn Ditze am Flipchart zu folgen. Hierfür könnte man z.B. einfach das Paint Programm am Computer nutzen.